Beitrag • 9 Min. Lesezeit

Large Language Models (LLMs) einfach erklärt

Large Language Models (LLMs) helfen KI-Systemen, Sprache auf menschlich wirkende Weise zu verarbeiten – und ermöglichen dadurch personalisierte und reaktionsschnelle Customer Experiences.

Zuletzt aktualisiert: 9. Januar 2026

Was ist ein LLM?Large Language Models (LLMs) sind fortgeschrittene Machine-Learning-Systeme, die auf riesigen Informationsmengen trainiert wurden. Sie können natürliche Sprache erkennen, vorhersagen und generieren, basierend auf Mustern, die sie in diesen Daten gelernt haben. Diese Modelle treiben die Fähigkeiten generativer KI voran, ermöglichen natürlichere, menschlich wirkende Gespräche über Tools und Plattformen hinweg und verbessern Service-Interaktionen sowie Customer Experiences (CX). |

Was als unterhaltsames Tool zur Generierung von Texten und Bildern begann, haben Large Language Models (LLMs) sich schnell zu viel mehr entwickelt. Laut Sam Altman, CEO von OpenAI, nutzen verschiedene Generationen diese KI-Tools auf unterschiedliche Weise.

Ältere Generationen nutzen LLMs als Ersatz für Google.

Millennials sehen in LLMs eine Art Lebensberater.

Gen Z verwendet sie wie ein Betriebssystem.

Im Geschäftsleben jedoch, wo außergewöhnliche Customer Experiences Sie vom Wettbewerb abheben können, sind KI-Agenten die nächste Generation von Kundenservice-Bots. Diese Chatbots, die von LLMs unterstützt werden, sind unverzichtbar, um mit den Fortschritten der KI Schritt zu halten – kein optionales Luxus-Feature.

In diesem Leitfaden erklären wir Schritt für Schritt, wie Large Language Models funktionieren, welche Vorteile und Einschränkungen Sie beachten sollten und wie sie die Zukunft des Kundenservice verändern.

Mehr in diesem Leitfaden:

- Wie funktionieren Large Language Models?

- Vorteile und Herausforderungen von LLMs

- Anwendungsfälle von Large Language Models

- Wie werden LLMs trainiert?

- Die Zukunft von Large Language Models

- Häufig gestellte Fragen

- Erstellen Sie in wenigen Minuten Ihren eigenen LLM-basierten Bot

Wie funktionieren Large Language Models?

Large Language Models (LLMs) basieren auf einer Transformer-basierten Deep-Learning-Architektur, einer Struktur, die speziell dafür entwickelt wurde, sequenzielle Daten wie Sprache zu verarbeiten.

In dieser Architektur befindet sich ein Mechanismus namens Self-Attention, der es dem Modell ermöglicht, jedes Wort in einem Satz im Verhältnis zu den anderen zu bewerten. Anstatt sich nur die letzten paar Wörter anzusehen, gewichtet Self-Attention die Bedeutung aller Wörter in einem Satz – egal, wo sie stehen. So erhält das Modell ein breiteres und genaueres Verständnis von Bedeutung, Kontext und Zusammenhängen.

Ein Beispiel, wie das in der Praxis funktioniert:

Da LLMs wie GPT-4 auf riesigen Datensätzen aus Büchern, Websites, Artikeln und mehr trainiert werden, hilft der Self-Attention-Mechanismus dem Modell, zu lernen, wie Sprache in realen Anwendungen funktioniert.

Es erkennt, wie sich der Tonfall verändert, wie die Wortstellung die Bedeutung verändert und wie man Ideen über längere Textpassagen kohärent hält. Das Ergebnis ist ein Modell mit Milliarden von Parametern, das in der Lage ist, Antworten zu verstehen und zu generieren, die menschliches Schreiben mit erstaunlicher Genauigkeit nachahmen.

Diese Struktur ist es, die Tools wie Zendesk AI Agents antreibt. Wenn Sie über eine Konversationsschnittstelle mit einem LLM interagieren, dann:

Verarbeitet es Ihre Eingabe

Analysiert den Kontext über Self-Attention

Generiert eine hochrelevante, flüssige Antwort

Darum gehen moderne LLMs in den Dialog statt nur zu reagieren. Sie können Informationen zusammenfassen, Folgefragen beantworten, den Ton anpassen und sogar Unklarheiten auflösen – auf eine Weise, die natürlich wirkt.

Über Konversations-KI greifen Zendesk AI Agents auf diese Modelle zu, um nuancierte Kundenanfragen zu verstehen und Anfragen zu bearbeiten, die früher zwingend menschliche Agenten erfordert hätten. Schon ab der ersten Interaktion interpretieren sie die Kundenabsicht mit Kontext und Klarheit.

Im Gegensatz zu veralteten Chatbot-Systemen, die auf starren Skripten basieren, können diese Agents komplexe Dialoge führen, beim Thema bleiben und Probleme von Kund:innen lösen – ohne dabei roboterhaft zu klingen oder Nutzende zu frustrieren.

Vorteile und Herausforderungen von LLMs

Mit jeder neuen Technologie kommen Vorteile und Stolpersteine. Mit den richtigen Leitplanken und Sicherheitszertifizierungen überwiegen die Vorteile von KI und LLMs jedoch die Herausforderungen.

Die Flexibilität von Large Language Models macht sie in vielen Branchen wertvoll. Neben dem Kundenservice werden LLMs etwa für Betrugserkennung im Finanzwesen, klinische Dokumentation im Gesundheitswesen, juristische Vertragsanalysen, Marketing-Content-Generierung und vieles mehr eingesetzt. Doch im Bereich CX sind ihre Vorteile besonders greifbar:

- KI-Agenten: Unternehmen können automatisch und eigenständig auf alle Interaktionen mit Kund:innen reagieren – unabhängig von Tageszeit oder Komplexität einer Anfrage.

- Wissensdatenbank-Erstellung: Mit Zendesk-Tools für generative KI und proprietären Systemen können Teams fehlende Support-Artikel identifizieren und mithilfe LLM-gestützter Tools sofort KI-gestützte Wissensdatenbank-Artikel aus Basisinformationen erstellen.

- Unterstützungstools für Agent:innen: Tools, die auf OpenAI-LLMs basieren, helfen Agent:innen, Makros zu erstellen, Tickets zusammenzufassen, persönliche Empfehlungen zu geben, Antwortoptionen zu erweitern und mehr.

- Sprach-Tools: Auf Large Language Models trainierte KI-Lösungen ermöglichen es Teams, automatisch Anrufe zusammenzufassen und Transkripte zu erstellen.

Um die Vorteile von Large Language Models effektiv zu nutzen, ist es entscheidend, den richtigen KI-Anbieter zu wählen. Beachten Sie bei der Auswahl einer Lösung diese Punkte, um typische Herausforderungen zu meistern:

- Sicherheit: LLMs können sensible Daten unbeabsichtigt preisgeben, wenn sie nicht mit geeigneten Schutzmechanismen eingesetzt werden. Zendesk bietet Unternehmens-Kontrollen auf höchstem Niveau, wie Advanced Data Privacy and Protection, um Interaktionen abzusichern.

- Halluzinationen: Unkontrollierte LLMs können ungenaue Ergebnisse erzeugen. Achten Sie darauf, dass Ihr AI as a Service (AIaaS)-Anbieter Parameter setzen und einen Bot bereitstellen kann, der speziell für Ihren Use Case entwickelt ist. KI-Agenten etwa sind für CX konzipiert und liefern präzise Antworten auf komplexe Fragen – anders als generische Optionen.

- Time to Value: Der Einsatz eines LLM-gestützten Bots erfordert Transformer, Hardware, Software und Expertise. Investieren Sie in eine Lösung wie Zendesk, um die Implementierung von Tagen auf Minuten zu verkürzen – ganz ohne technisches Spezialteam für Einführung und Start der LLM-Technologie.

LLMs sind nicht perfekt. Doch in Kombination mit zweckgerichtetem Design und transparenter Kontrolle erschließen sie zuverlässigere Automatisierungen, die die Kundenzufriedenheit erhöhen und operative Belastungen senken.

Anwendungsfälle von Large Language Models

Die praktischen Anwendungen von Large Language Models gehen weit über einfache Chatbot-Funktionen hinaus – wie das Führen von Gesprächen ohne Training oder die Anpassung an Marken-Tonfall und -Stimme. KI im Kundenservice zeigt, wie sich LLM-gestützte Bots zu autonomen Agents entwickeln, die End-to-End-Support bieten.

Laut dem Zendesk Customer Experience Trends Report 2026 werden 87 Prozent der CX-Vorreiter:innen bis 2027 Erlebnisse entwerfen, bei denen Konsument:innen KI-Assistenten entlang der gesamten Customer Journey einsetzen.

Es ist daher kaum verwunderlich, dass so viele Unternehmen auf den LLM-Bot-Zug aufspringen. Zendesk AI Agents zeigen deutlich, was mit einer Konversationsschnittstelle auf Basis von Large Language Models möglich ist:

- Skalieren Sie Ihren Support bei geringeren Kosten pro Interaktion: KI-Agenten ermöglichen es Teams, mehr Support-Tickets zu bearbeiten und unerwartete Service-Spitzen zu bewältigen – ohne zusätzliche Stellen oder Budgetbelastungen.

- Erstellen Sie in Minuten einen Bot: Verbinden Sie Ihre Wissensdatenbank mit einer vortrainierten generativen KI-Lösung wie Zendesk, und Ihr Bot kann sofort Kund:innen auf natürliche, dialogorientierte Weise unterstützen – mit wenig bis gar keinem technischen Training.

- Bieten Sie Kund:innen 24/7-Support: Bots müssen nicht schlafen, essen oder Urlaub machen. Sie bieten rund um die Uhr Betreuung und sofortige Lösungen für Anliegen wie Bestellstatus prüfen, Transaktionsinformationen anfordern oder ein Passwort ändern. Autonome Bots wie KI-Agenten können sogar komplexere Interaktionen von Anfang bis Ende lösen.

- Bieten Sie mehrsprachigen Support: LLM-basierte Bots und KI-Agenten übersetzen sofort Inhalte Ihrer Wissensdatenbank und führen Gespräche mit muttersprachlicher Kompetenz. So gewährleisten Sie denselben Kundenservice in allen Sprachen – ohne unübersichtliche FAQ-Seiten oder verwirrende Dialoge wie bei Chatbots der älteren Generation.

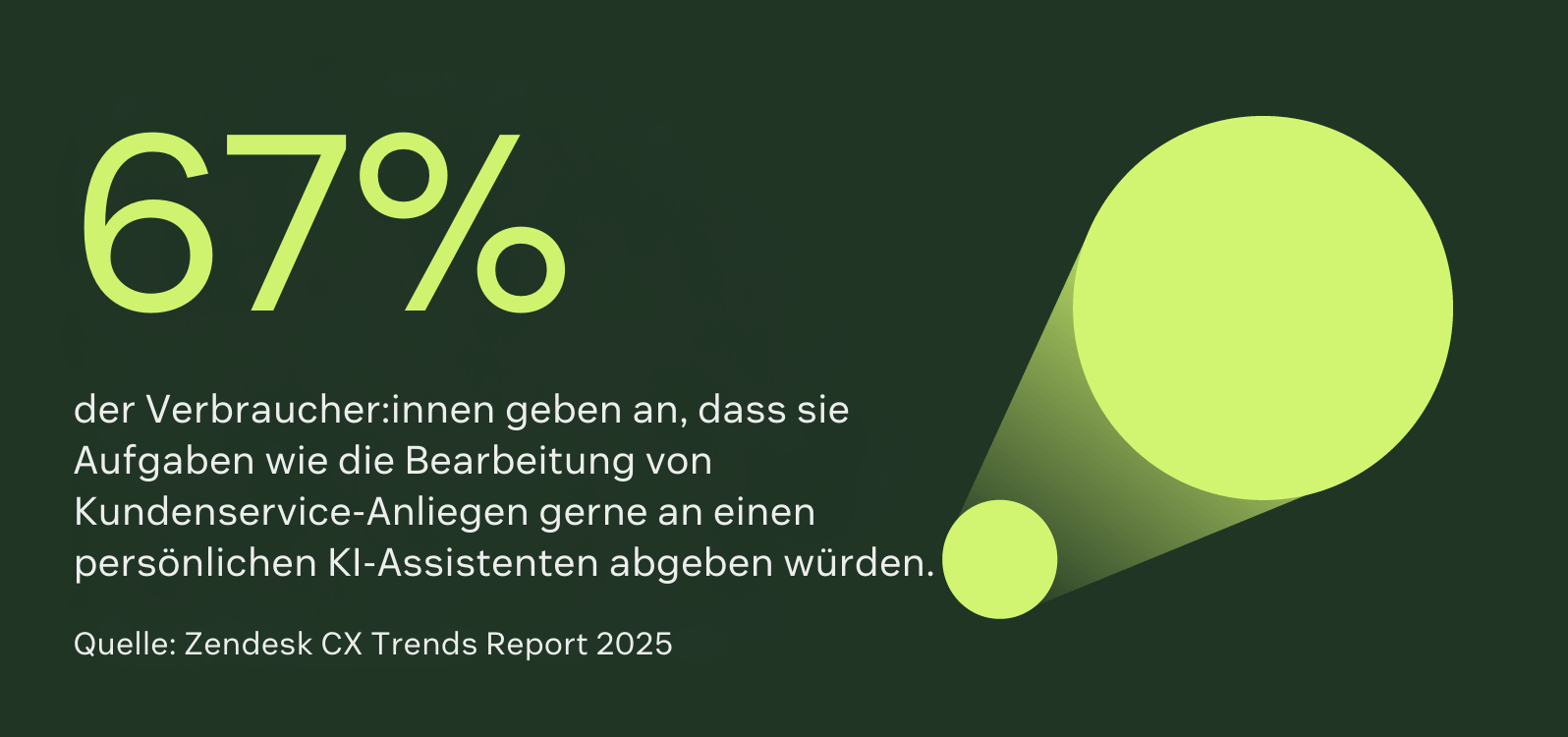

- Erleichtern Sie die Arbeit menschlicher Agent:innen (und machen Sie sie erfüllender): Automatisierung hebt die Rolle Ihrer menschlichen Support-Agent:innen zu KI-Managern und Redakteur:innen. Während LLMs Routine-Interaktionen übernehmen, können sich Support-Teams auf Arbeit konzentrieren, die Problemlösung, Nuancen und Empathie erfordert. Das reduziert Fluktuation, schafft Raum für Upskilling und ermöglicht erfüllendere Karrieren.

Dies ist keine vollständige Liste der LLM-Anwendungsfälle, aber es sind die gängigsten und wertvollsten Möglichkeiten, KI und Automatisierung einzusetzen.

Wie werden LLMs trainiert?

Large Language Models können Milliarden von Parametern haben – mit Knoten, Schichten, Gewichtungen und Verzerrungen, die zusammen ein Modell bilden. Mithilfe riesiger Datensätze wenden LLMs selbstlernende Techniken an, um das nächste Token in einer Sequenz vorherzusagen.

Wenn eine Vorhersage falsch ist, passt das Modell seine internen Parameter an, um künftige Vorhersagen zu verbessern. Im Laufe der Zeit entsteht so ein Modell, das kohärente, kontextbezogene Texte generieren kann.

Der Trainingsprozess von LLMs ist komplex und umfasst mehrere Phasen:

- Pre-Training: Das Modell lernt aus riesigen Datensätzen, die aus Büchern, Artikeln, Foren und Code-Repositories stammen. So entwickelt es ein allgemeines Verständnis für Grammatik, Ton und Struktur.

- Fine-Tuning: Nach dem Pre-Training können LLMs mit branchenspezifischen oder aufgabenorientierten Daten angepasst werden. Dies schärft den Fokus und verbessert die Genauigkeit für gezielte Anwendungsfälle wie Kundenservice oder juristische Analysen.

- Zero-Shot Learning: Basis-LLMs reagieren auf Anfragen ohne konkrete Beispiele. Diese Art des Lernens führt oft zu variabler Antwortqualität.

- Few-Shot Learning: LLMs erhalten einige Beispiele und können ihre Antworten in spezifischen Situationen durch neue Daten verbessern.

- Chain-of-Thought Prompting: Dieser Ansatz führt das Modell durch schrittweise Denkprozesse, um komplexe Probleme klarer zu lösen.

- Multimodales Training: Neuere Large Language Models werden nicht nur mit Text trainiert, sondern auch mit Bildern, Audio und sogar Video. Dadurch können sie Inhalte in verschiedenen Formaten verstehen und generieren.

Darum sind generative KI-Tools auf Basis von Large Language Models so anpassungsfähig. Sie sind keine regelbasierten Systeme, sondern probabilistisch, flexibel und entwickeln sich kontinuierlich weiter – durch neue Daten und Prompting-Techniken.

Zendesk AI Agents basieren auf den Large Language Models von OpenAI und sind auf Milliarden realer Kundeninteraktionen trainiert. Dadurch können sie komplexe Kundenprobleme lösen – ohne roboterhaft zu klingen oder aufwendige Einrichtung zu benötigen. |

Die Zukunft von Large Language Models

Auch wenn es vielleicht nicht so griffig klingt wie LLMs, erwarten wir, dass „angemessen große“ Sprachmodelle in den kommenden Jahren die heutigen Modelle ablösen werden. Mit generativer KI können diese Sprachmodelle mit Dutzenden statt Hunderten Milliarden Parametern laufen.

Mittlere und kleinere Sprachmodelle sind günstiger im Betrieb und erleichtern es, die Vorteile von CX-Automatisierung zu nutzen.

Für die Zukunft rechnen wir außerdem mit:

Branchenspezifischen Modellen, die auf Domänendaten für Finanzen, Recht, Gesundheitswesen und andere regulierte Branchen trainiert sind

Multimodalen Fähigkeiten, sodass Modelle mit Bildern, Videos und Sprache neben Text arbeiten können

Intelligenteren Assistent:innen, die über einfache Q&A hinausgehen und Aufgaben erledigen, Aktionen planen und sich in Drittanbietersysteme integrieren

Schnellerem Fine-Tuning von Workflows, damit Unternehmen LLMs leichter an Tonalität, Marke und Use Cases anpassen können

Weiterentwickelten KI-Assistenten, einschließlich Alexa und Siri

LLMs entwickeln sich ständig in Größe und Fähigkeiten weiter – doch der Fokus verschiebt sich hin zu Präzision, Geschwindigkeit und Integration. Darum ist es wichtig, dass Teams, die diese Technologie nutzen, sowohl die aktuellen als auch die künftigen Möglichkeiten verstehen.

Häufig gestellte Fragen

Erstellen Sie in wenigen Minuten Ihren eigenen LLM-basierten Bot

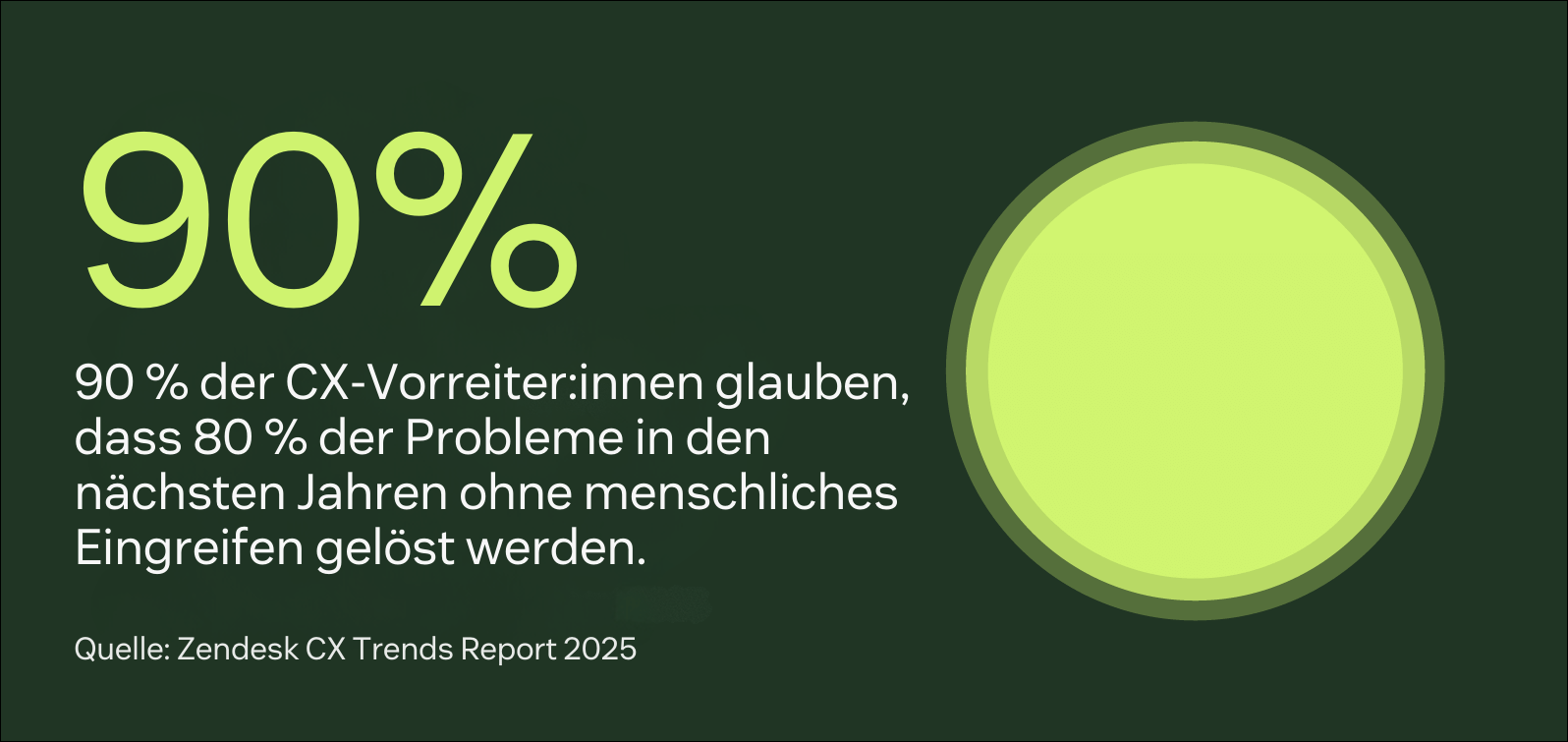

Large Language Models und KI-Chatbots können komplex wirken – aber Zendesk-KI macht es einfach. Unsere Lösung ist auf Large Language Models und über 18 Millionen echte Kundenservice-Interaktionen vortrainiert. Innerhalb weniger Minuten können Sie Zendesk AI Agents starten, die bis zu 80 Prozent aller Interaktionen automatisch abwickeln – ohne Einbußen bei Qualität oder Vertrauen der Kund:innen.

Zendesk liefert einen klaren Weg zu echtem Mehrwert. Automatisieren Sie mehr, reduzieren Sie Stress und bieten Sie präzise, dialogorientierte KI-Erlebnisse, die Ihre Kund:innen wirklich schätzen. Probieren Sie Zendesk AI Agents noch heute aus.